Motivation

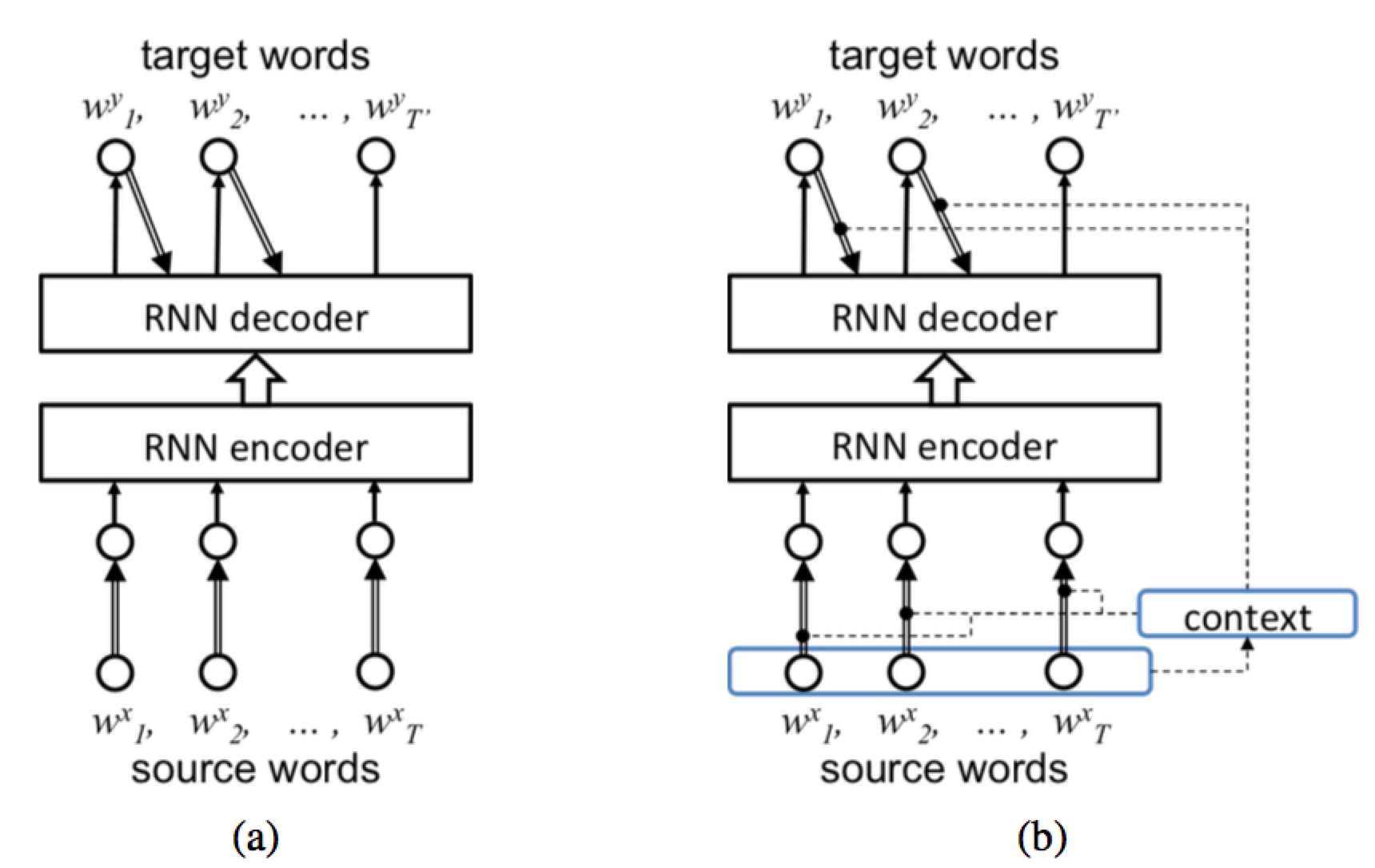

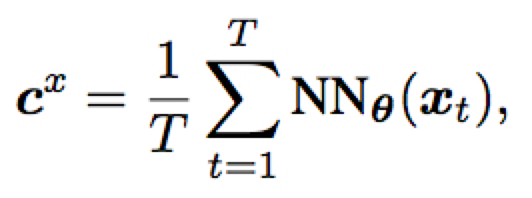

灵感来源于作者之前的有关 word embedding 的工作。( Context-dependent word representation for neural machine translation)作者发现 word embedding vectors 中的每一维在不同的 context 下表示出不同的含义,通过考虑这一 context 信息来在源语和目标语的 embedding 上加上 mask ,能够得到更好的翻译效果。(contextualization)

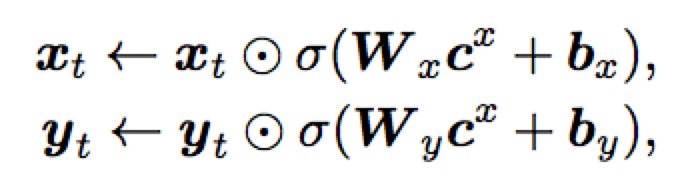

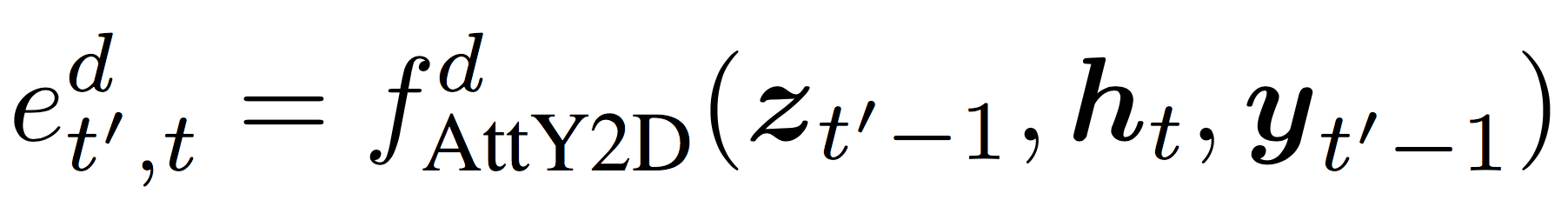

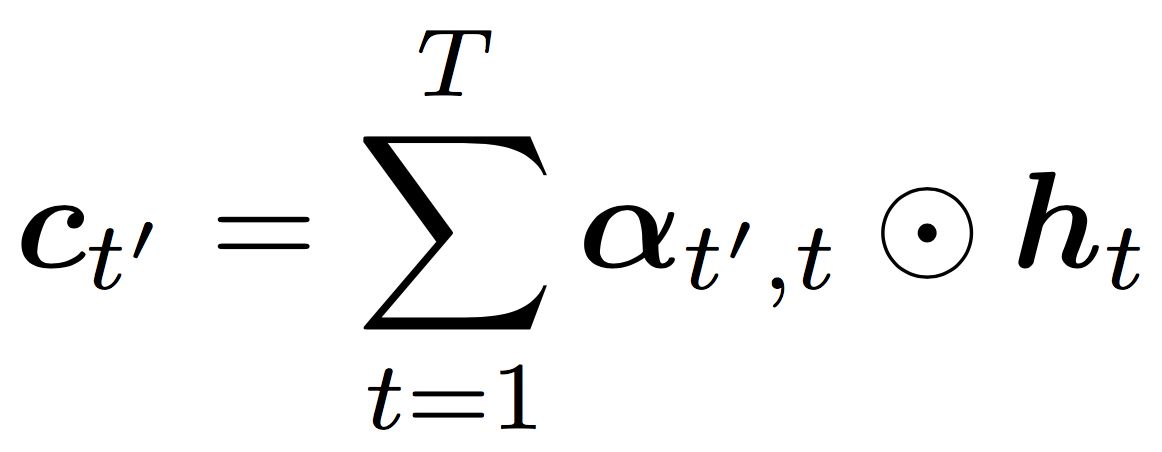

作者认为目前的 attention 机制局限在每一个 context vector 只给一个标量的 attention 值,然后计算加权和。实际上,可以针对 context vector 的每一个维度计算一个 attention 值,从而使得 attention 做的更加精细。

Method

这里通过一个全连接神经网络来建模 $f_{AttY2D}^{d}$

Experiments

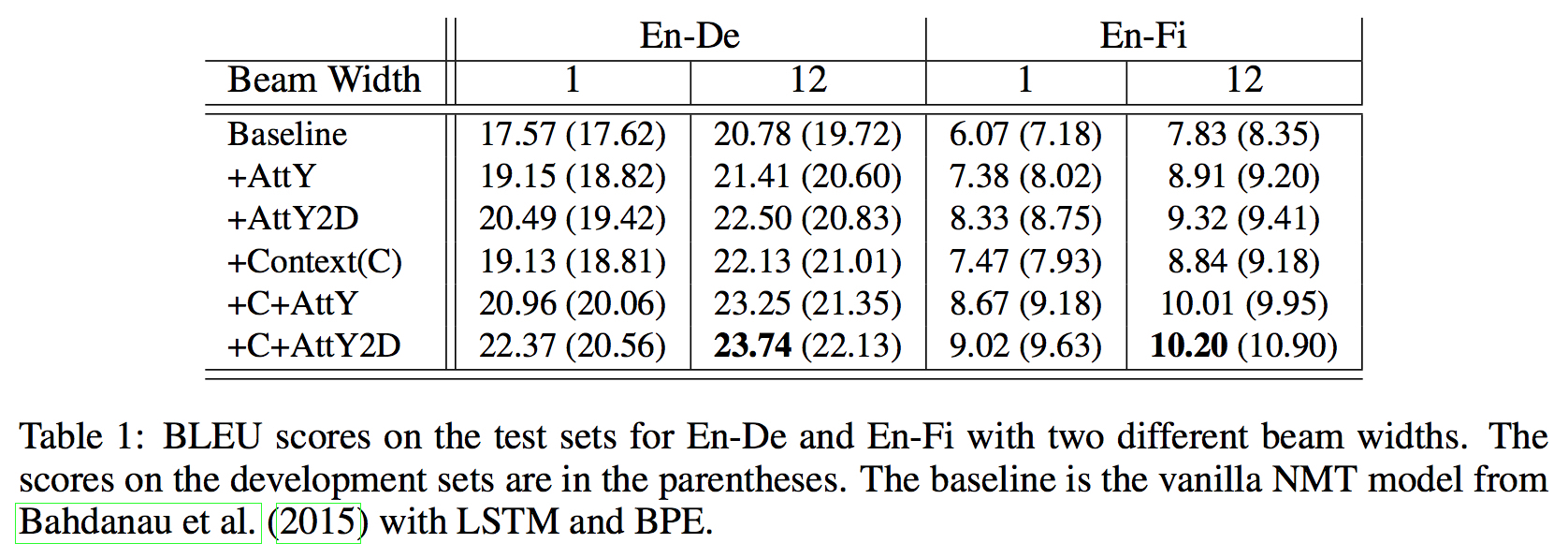

BLEU

BLEU 值是与 RNNSearch 做比较。

其中 +C 表示采用了 contextualization ,即 Motivation 部分介绍的方法。最好的效果比 Baseline 好1.4 BLEU。

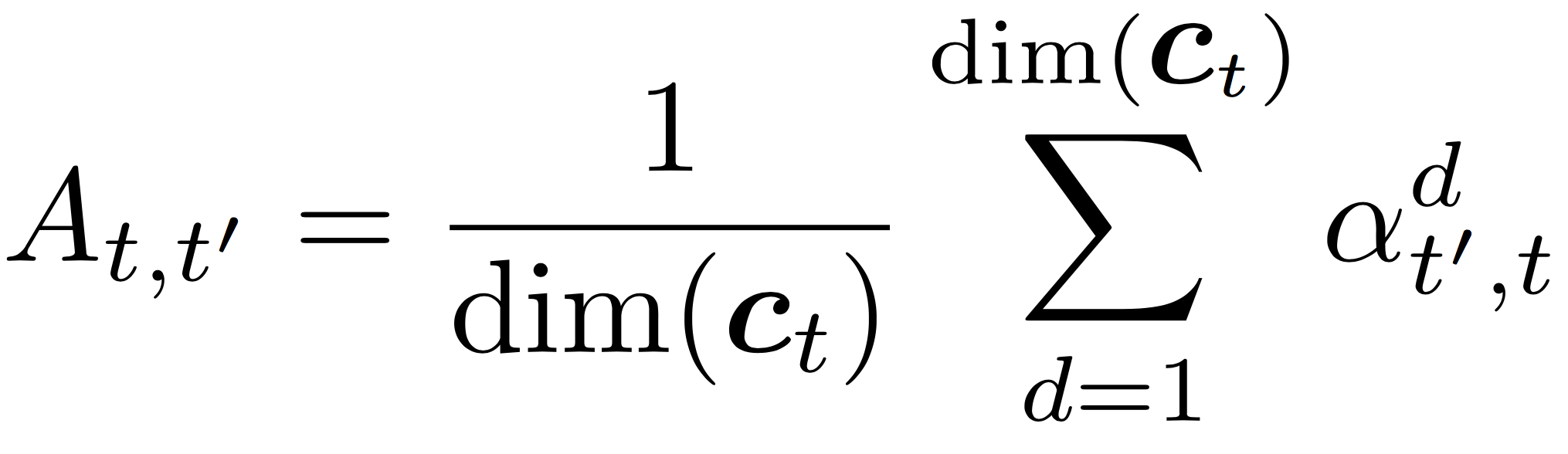

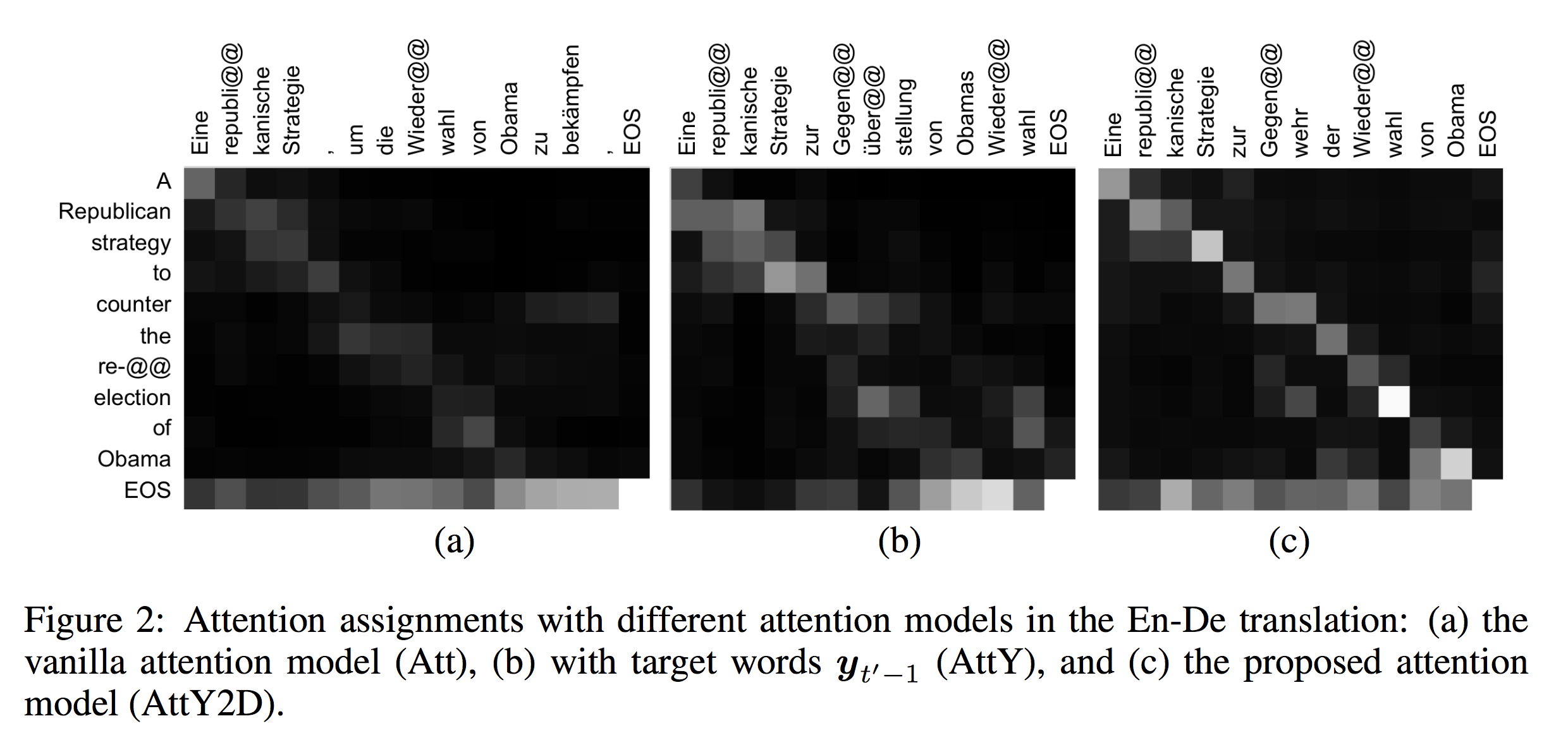

Alignment

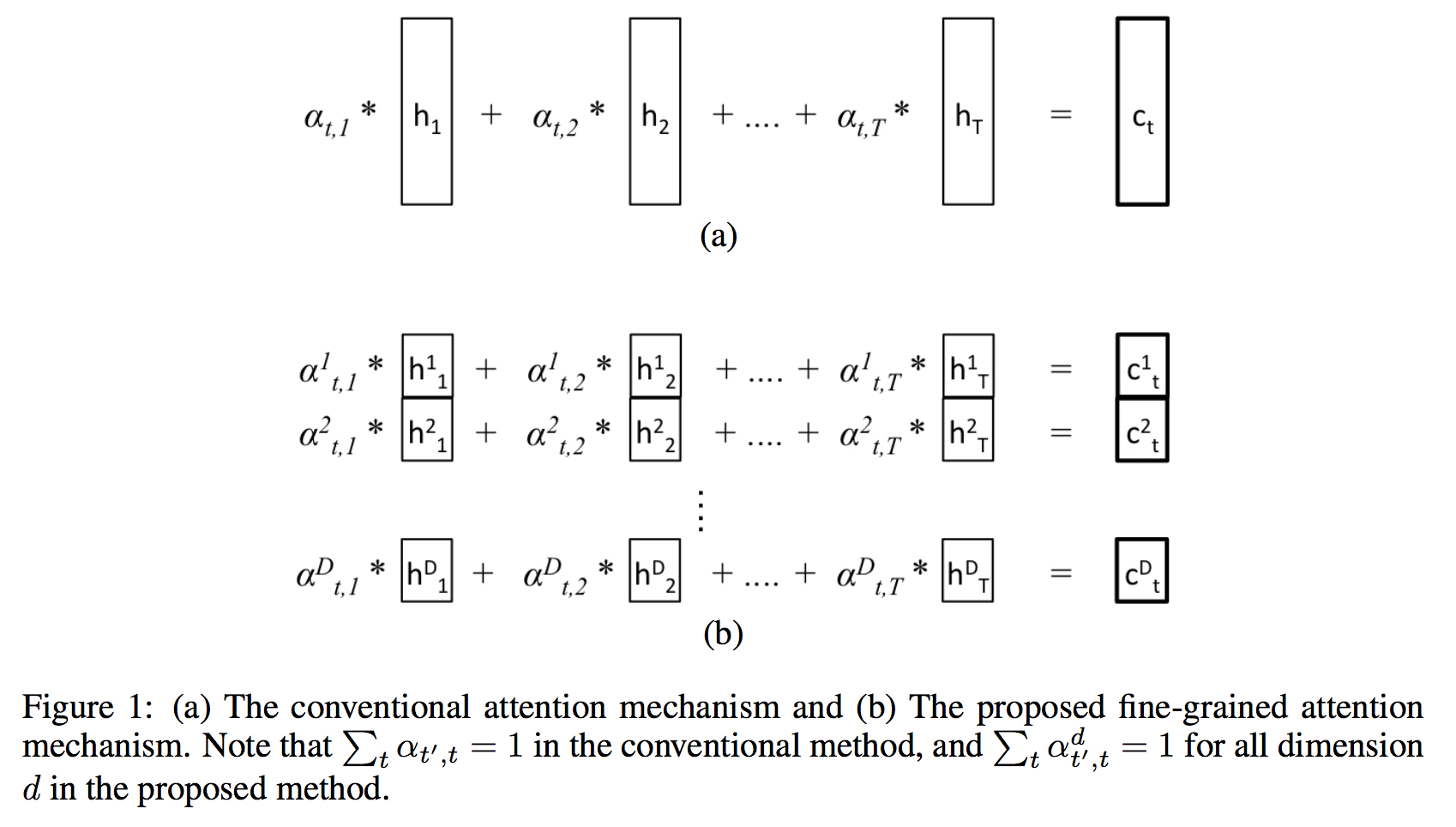

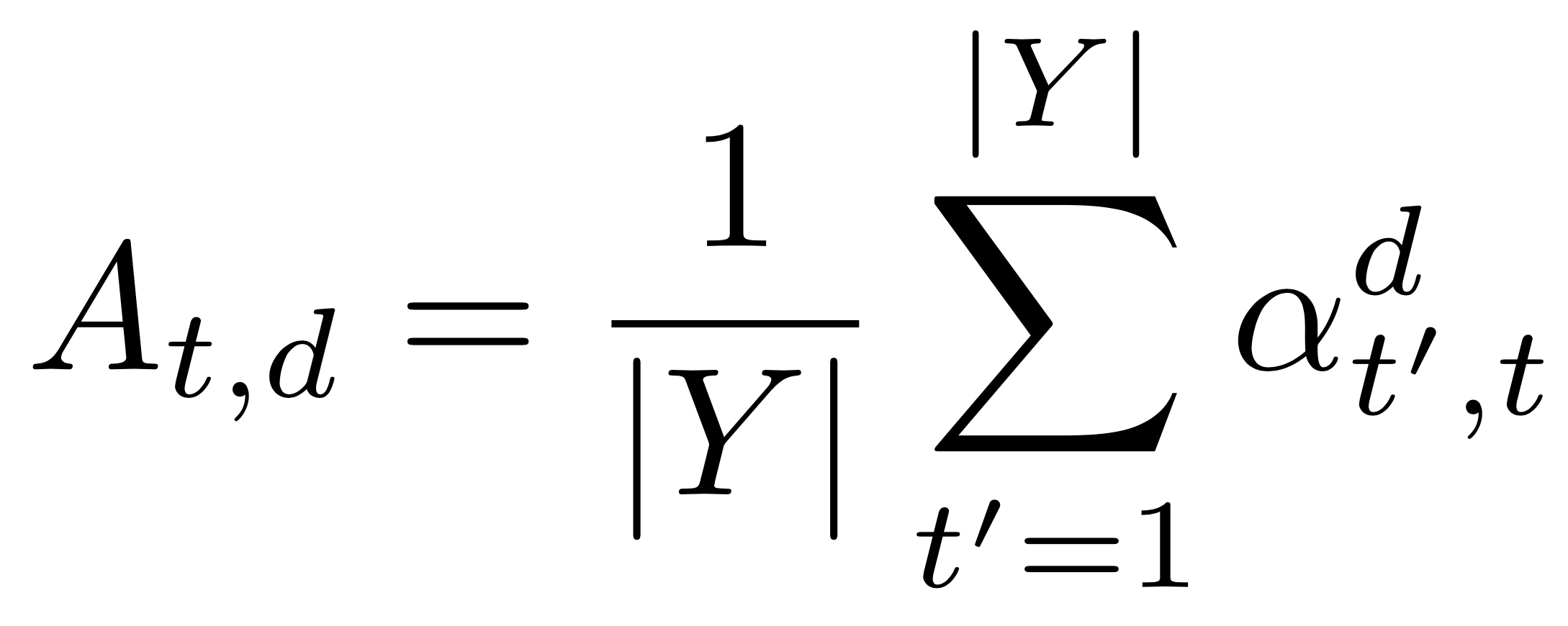

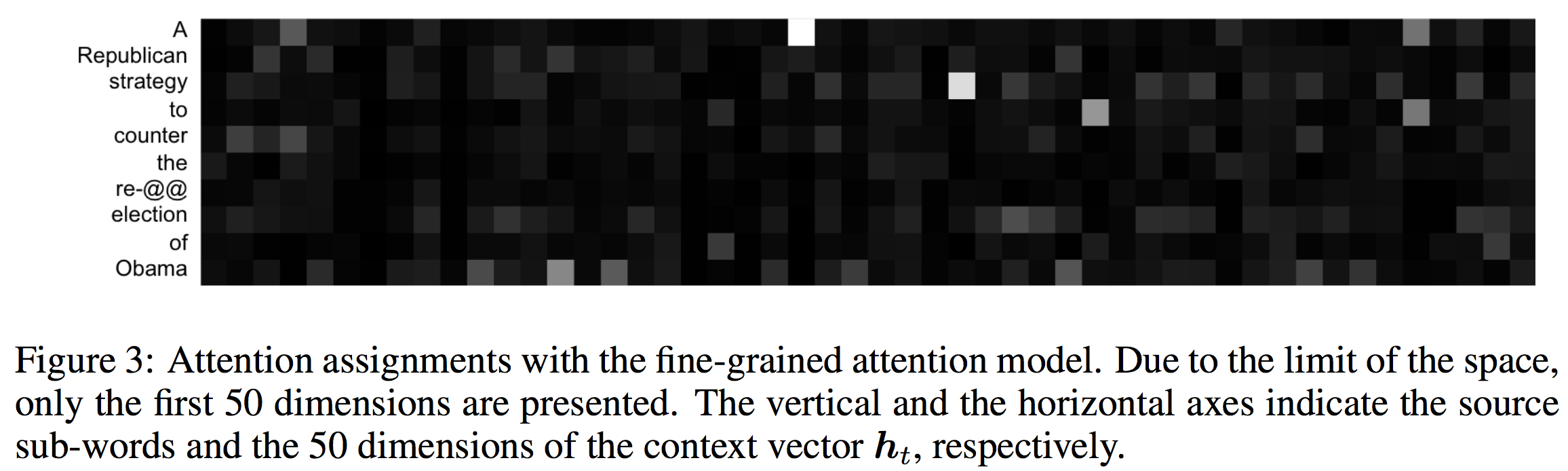

- 维度平均

- Target 平均

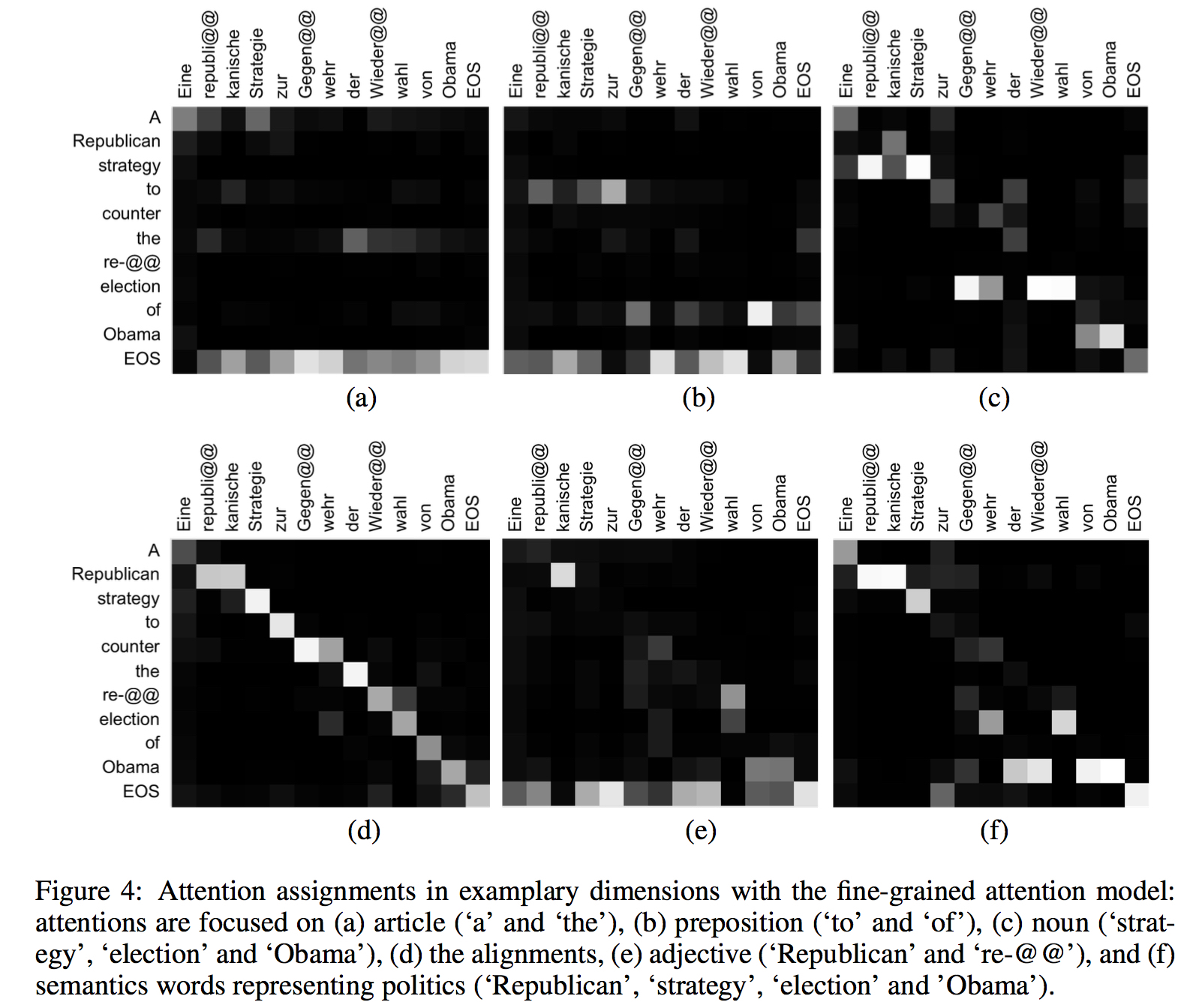

表示 context vector 中的每个维度对该词的翻译的影响。这里看到结果非常稀疏。

- context vector 确实在翻译不同语句的时候,其不同维度得到的 activation 值所表现出来的观察的点也全都不一样。

思考

1.